Real-Time Grasp Detection Using Convolutional Neural Networks 인공지능로봇/로봇손지능2018. 11. 13. 10:30

이 논문은 무려 99회의 인용횟수를 기록한 CNN을 이용한 실시간 파지에 관한 유명한 논문이다.

[PDF]Real-Time Grasp Detection Using Convolutional Neural Networks

https://research.google.com/pubs/archive/43875.pdf

J Redmon 저술 - 99회 인용 - 관련 학술자료Real-Time Grasp Detection Using Convolutional Neural Networks ... We evaluate on the Cornell Grasp Detection Dataset, an .... single, efficientpipeline.

Joseph Redmon1 , Anelia Angelova2

1University of Washington 2Google Research

!. 서론

센서를 이용하여 환경을 이해(인식)한다는 것은 지극히 어려운 일이다. 우리가 환경을 이해할 때는 일단 주어진 영상을 세그먼트로 나누고, 각각의 세그먼트를 구별하여 인식한다. 그러나 물체가 겹쳐지기도 하고, 형태가 비슷한 물체간의 모호성으로 인해, 시각인식 문제는 로봇시스템에 있어 아직도 난제로 남아 있다. 인간은 물체를 보면(novel objects) 직관에 의해 그 물체가 무엇인지 인식한다. 인식할 뿐아니라 그 물체를 핸들링하는 방법까지도 알아 낸다. 즉 어떻게 집을 것인지 어떻게 놓을 것인지 등을 알아 낸다. 그러나 기계가 이일을 해내기 위해서는 아직 인간과 커다란 갭을 이겨내야 한다. 이것이 기계지능을 연구하는 연구자들의 몫이다. 파지인식을 연구하는 사람들은 물체를 보고 어떻게 잘 집을 수 있는지 하는 문제를 연구한다.

일단 데이터셋으로는 이 분야에서 코넬 파지 감지 데이터셋(Cornell Grasp detection Dataset)이 있다. 그림은 이를 보여준다.

최근의 연구[1],[2]로는 13.5초만에 75%의 정확도를 가지고 돌아 가고 있다. 즉 이미지를 보여주면 13.5초만에 그리퍼를 어떻게 움직여야 하는지 알려주는 것이다. 이전의 연구 슬라이딩 윈도우를 사용하기 때문에 많은 시간이 소요된다. 이 경우 Single network을 사용하여 시간을 많이 줄였다. 초당 13 frmes을 처리할 수 있으며, 정확도는 88%에 달한다.

2. 관련연구

일단 물체의 3차원 모델이 주어진 경우, 좋은 파지 위치를 알아내는 연구는 많이 있어왔다. [3]-[7]. 이러한 연구는 물체에 3차원 정보가 완벽할 때 유효하다. 그러나 물체에 대한 완전한 정보가 얻기 힘든 경우가 실제 상황에서 많이 발생한다. 떠라서 물체에 대한 완벽한 정보가 주어지지 않은 경우에 대해서서도 물체를 잘 잡을 수 있는 일반적인 접근 방법이 필요한 것이다. 로봇시스템은 물체 인식[8]이나, 감지[9][10], 매핑[11][12]등의 문제에서 일반적으로 RGB-D센서를 사용한다. 키넥트와 같은 RGB-D센서는 로봇이 3차원 환경과 반응하며 작동하기에 매우 훌륭한 깊이정보를 제공한다. 파지감지에 대한 최근 연구는 RGB-D데이터로부터 파지위치를 찾는 문제에 촛점을 맞춘다.[13] . Lenz등은 파지감지를 위한 컨벌루션 신경망을 성공적으로 사용하였다. 이 신경망은 슬라이딩 윈도우 감지 파이프라인에서 분류기로 작동한다.

3. Problem description

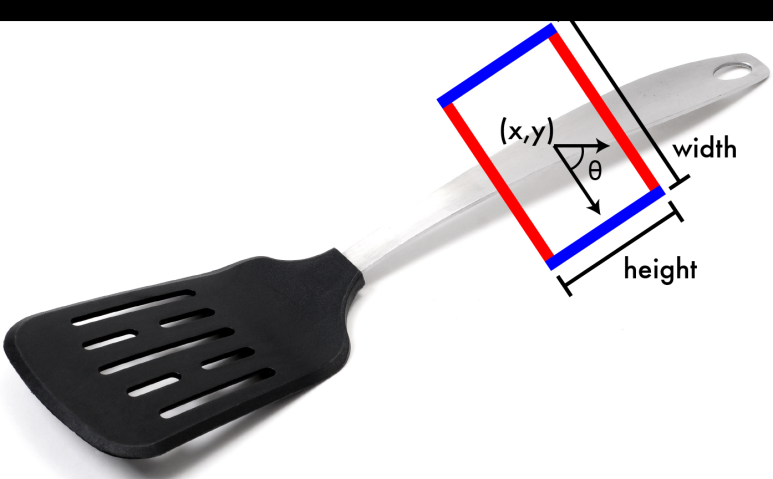

일단 물체영상이 얻어지면, 그 물체를 안전하게 집어 들기 위한 적당한 방법을 찾아야 한다. 이를 위해 5차원의 정보가 필요하다. 그림과 같이 직각 사각형의 중심 위치에 해당하는 2차원 정보와, 방향, 그리고 높이와 폭이다.

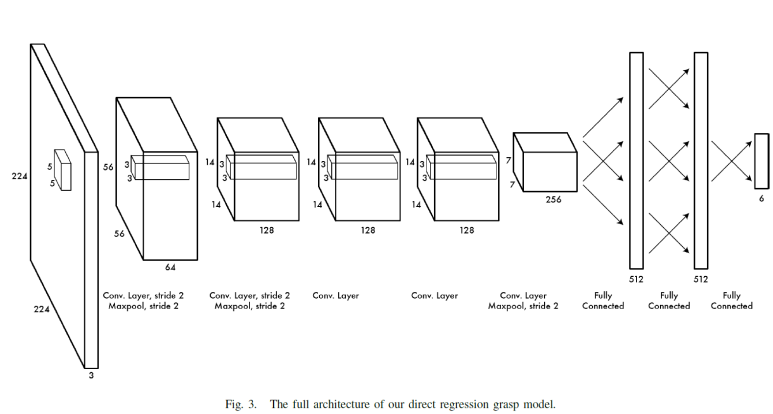

4. Grasp Detection with Neural networks

Krizhevsky에 의해 제안된 AlexNet을 사용한다.[15]

5. Experiments and Evaluation

코넬 파지 데이터셋[19]은 240종의 물체 885개의 이미지를 담고 있다. 그리고 그라운드트러스 파지 레이블을 갖고 있다.

- rectangle metric accuracy

6. 결과

- direct regression model

7. Discussion

- Image dataset에서 미리 학습된 효과가 미치는 영향

- RGB정보에서 B대신 Depth정보를 사용하는 효과

8. 결론

Grasping detection과 object classification이 정확도를 유지하면서 결합될 수 있음을 보여줌.

참고문헌

[1] I. Lenz, H. Lee, and A. Saxena, “Deep learning for detecting robotic grasps,” in Proceedings of Robotics: Science and Systems, Berlin, Germany, June 2013.

[2] Y. Jiang, S. Moseson, and A. Saxena, “Efficient grasping from rgbd images: Learning using a new rectangle representation,” in IEEE International Conference on Robotics & Automation (ICRA). IEEE, 2011, pp. 3304–3311.

[3] A. Bicchi and V. Kumar, “Robotic grasping and contact: A review,” in IEEE International Conference on Robotics & Automation (ICRA). Citeseer, 2000, pp. 348–353.

[4] A. T. Miller, S. Knoop, H. I. Christensen, and P. K. Allen, “Automatic grasp planning using shape primitives,” in IEEE International Conference on Robotics & Automation (ICRA), vol. 2. IEEE, 2003, pp. 1824–1829.

[5] A. T. Miller and P. K. Allen, “Graspit! a versatile simulator for robotic grasping,” Robotics & Automation Magazine, IEEE, vol. 11, no. 4, pp. 110–122, 2004.

[6] R. Pelossof, A. Miller, P. Allen, and T. Jebara, “An svm learning approach to robotic grasping,” in IEEE International Conference on Robotics & Automation (ICRA), vol. 4. IEEE, 2004, pp. 3512–3518.

[7] B. Leon, S. Ulbrich, R. Diankov, G. Puche, M. Przybylski, A. Morales, ´ T. Asfour, S. Moisio, J. Bohg, J. Kuffner, et al., “Opengrasp: a toolkit for robot grasping simulation,” in Simulation, Modeling, and Programming for Autonomous Robots. Springer, 2010, pp. 109–120.

[8] K. Lai, L. Bo, X. Ren, and D. Fox, “A large-scale hierarchical multi-view rgb-d object dataset,” in IEEE International Conference on Robotics & Automation (ICRA). IEEE, 2011, pp. 1817–1824.

[9] ——, “Detection-based object labeling in 3d scenes,” in IEEE International Conference on Robotics & Automation (ICRA). IEEE, 2012, pp. 1330–1337.

[10] M. Blum, J. T. Springenberg, J. Wulfing, and M. Riedmiller, “A learned feature descriptor for object recognition in rgb-d data,” in IEEE International Conference on Robotics & Automation (ICRA). IEEE, 2012, pp. 1298–1303.

[11] P. Henry, M. Krainin, E. Herbst, X. Ren, and D. Fox, “Rgb-d mapping: Using depth cameras for dense 3d modeling of indoor environments,” in In the 12th International Symposium on Experimental Robotics (ISER). Citeseer, 2010.

[12] F. Endres, J. Hess, N. Engelhard, J. Sturm, D. Cremers, and W. Burgard, “An evaluation of the rgb-d slam system,” in IEEE International Conference on Robotics & Automation (ICRA). IEEE, 2012, pp. 1691–1696

[13] A. Saxena, J. Driemeyer, and A. Y. Ng, “Robotic grasping of novel

objects using vision,” The International Journal of Robotics Research,

vol. 27, no. 2, pp. 157–173, 2008.

[15] A. Krizhevsky, I. Sutskever, and G. E. Hinton, “Imagenet classification

with deep convolutional neural networks,” in Advances in neural

information processing systems, 2012, pp. 1097–1105.

[19] “Cornell grasping dataset,” http://pr.cs.cornell.edu/grasping/rect data/

data.php, accessed: 2013-09-01.

'인공지능로봇 > 로봇손지능' 카테고리의 다른 글

| RGBD Object labeling using CNN (1) | 2018.11.13 |

|---|---|

| Use case (0) | 2018.11.13 |